DeepSeek是一个出色的AI工具。然而,由于种种原因,许多AI爱好者希望在自己的设备上本地部署它。今天,我们将指导您在不同设备上进行DeepSeek本地部署,以帮助您实现更优质、更私密的AI交互体验。

DeepSeek离线部署是否安全?

DeepSeek安全吗?根据其隐私政策,某些数据管理细节仍存在不确定性。例如,该政策提到用户数据将存储在中国的安全服务器上,但未明确说明这些数据会被保留多久,或者是否可以永久删除。

尽管如此,根据TikTok、小红书、Lemon8等过往的案例来看,DeepSeek的用户数据遭遇重大问题的可能性极低。但需要注意的是,如果您在DeepSeek上发布不当内容,您的数据仍有可能被提交给相关机构。

因此,如果您对DeepSeek的数据管理方式感到不满意,在电脑上进行本地部署是一个不错的替代方案。

小贴士:

另一种保护数据的方法是使用VPN,例如闪连VPN(LightningX VPN)。它是一款适用于AI工具(如 ChatGPT、Gemini、Claude 和 DeepSeek)的优秀 VPN,支持Android、iOS、Windows、macOS、Linux、Apple TV和Android TV。该VPN可以让您切换到全球50+个国家的2000台服务器,操作简单、速度极快且稳定可靠。目前,它还为新用户提供免费试用。

DeepSeek本地部署配置要求

以下是在手机,电脑等设备上本地部署DeepSeek的硬件要求。

Android:

- 处理器:骁龙 845,骁龙 8 Gen 2/3 或同等规格处理器

- 内存:6GB、8GB、12GB 或更高

- 存储空间:8GB、12GB 或更大可用空间

示例设备:OnePlus 6、Samsung Galaxy S9、小米 Pocophone F1、Google Pixel 3、Sony Xperia XZ2

iOS:

- 内存:8GB、16GB 或更高

- 适用于小型模型:iPhone 15 Pro、iPad Air(8GB 内存)

- 适用于大型模型:iPad Pro(16GB 内存)

Windows:

- 操作系统:Windows 10 或更高版本

- 内存:至少 8GB(适用于 1.5B 等小型模型),建议 16GB 或更高(适用于更大型模型)

- 存储空间:SSD,至少 50GB 可用空间

- GPU:支持 CUDA 的 NVIDIA GPU(建议 RTX 2060 或更高,以获得更好性能)

macOS:

- 操作系统:macOS 11 Big Sur 或更高版本

- 处理器:多核 CPU(建议 Apple Silicon M1/M2 或 Intel Core i5/i7/i9)

- 内存:至少 8GB(建议 16GB 以上以运行更大型模型)

- 存储空间:至少 10GB 可用空间(建议 50GB 或以上以运行更大型模型)

在Android和iOS上进行DeepSeek本地部署或下载App

如果您想在移动设备上使用DeepSeek,可以直接从Google Play商店或App Store下载官方应用,或者下载DeepSeek本地文件以离线运行它。

通过Google Play商店或App Store下载

以下是获取DeepSeek应用的步骤:

- 在您的移动设备上打开Google Play商店或App Store,然后搜索DeepSeek。

- 下载并安装应用。

- 完成后,您可以注册DeepSeek账户,启用R1模型,然后开始您的DeepSeek之旅。

在移动设备上本地部署DeepSeek

如果您希望在移动设备上本地运行DeepSeek,需要使用终端模拟器,例如:

- PocketPal AI(适用于Android 和iOS,最适合初学者)

- Termux(适用于Android)

- Termius(适用于iOS)

以下是使用PocketPal AI运行DeepSeek的方法:

- 从Google Play商店或App Store安装PocketPal AI。

- 打开应用,点击屏幕右下角的 “Go to Models”(进入模型)。

- 点击右下角的 “+”,然后选择 “Add from Hugging Face”(从Hugging Face添加)。这时,您将看到Hugging Face库中的所有AI模型。

- 在底部搜索栏中输入 “DeepSeek”,即可看到所有DeepSeek AI模型。

- 下载适合您设备的模型,例如7B是一个适中的选择。您还可以参考前文提到的设备要求。

- 下载完成后,返回 “Models” 页面,确认模型是否正确安装。

- 在下载的模型下方点击 “Settings”(设置),然后在N PREDICT选项中将Token 限制设置为4096(以提供更好的生成和理解体验)。然后点击“Save Changes”(保存更改)。

- 在“Settings”旁边点击“Load”(加载)。

- 完成!现在,您可以使用PocketPal AI提供的图形化界面,与本地运行的DeepSeek模型进行交互。

使用Ollama在Windows/Mac/Linux上将DeepSeek本地部署

Ollama是最适合初学者在本地部署LLM的工具之一。此外,在Windows、macOS和Linux上使用Ollama设置离线版DeepSeek的方式几乎相同,主要包括两个步骤。

第一步:下载Ollama桌面应用

前往Ollama官网并点击右上角的“下载”按钮。选择适合您的操作系统。

Windows:可以直接安装Ollama。

macOS:由于macOS下载的文件是.dmg格式,因此需要将Ollama图标拖入“应用程序”文件夹才能运行Ollama。

Linux:在终端中依次输入以下命令,每条命令的作用:第一条命令安装Ollama;第二条命令启动Ollama服务;第三条命令验证安装是否成功,并显示已安装的版本。

- curl -fsSL https://ollama.com/install.sh | sh

- ollama serve

- ollama –version

如果Ollama安装成功,应该会显示版本号。

注意:在命令提示符中输入代码时要小心,不当的命令可能会导致数据丢失。

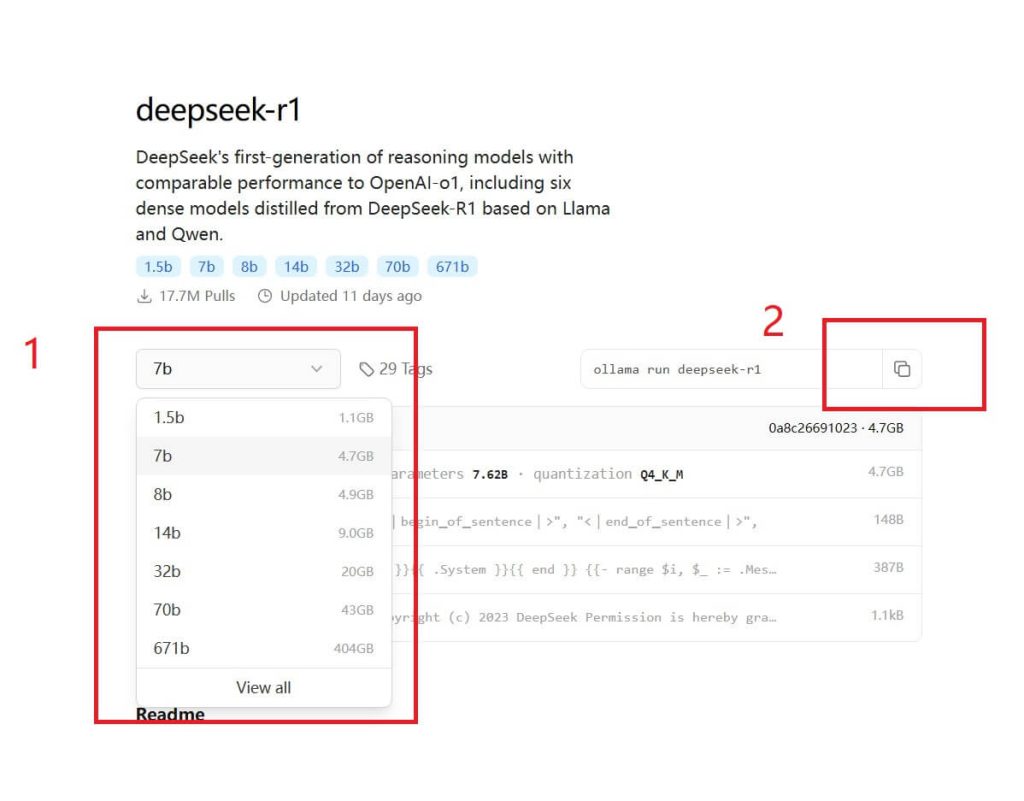

第二步:通过命令行本地部署DeepSeek

1. 打开电脑上的命令提示符 (Command Prompt) 或终端 (Terminal)。

2. 在Ollama官网查找所需的DeepSeek模型,并复制相应的代码。Ollama目前支持 DeepSeek R1、Coder、V2.5、V3等多个版本。不同模型的参数要求在本文的第二部分有详细说明。

3. 将复制的代码粘贴到命令提示符或终端中,等待DeepSeek模型安装完成。

4. 安装完成后,即可输入提示词,与DeepSeek AI进行交互。

5. 要退出对话,请按Ctrl + D组合键。

第三步:如果您想通过Web UI访问DeepSeek

如果希望在用户友好的Web界面上使用本地化的DeepSeek模型,可以安装Open WebUI,它与Ollama兼容。

1. 在电脑上安装并设置Python和Pip。

2. 打开命令提示符或终端,输入以下命令安装Open WebUI:

pip install open-webui

3. 运行DeepSeek模型(以DeepSeek R1为例):

ollama run deepseek-r1:1.5b

4. 启动Open WebUI:

open-webui serve

5. 在浏览器中访问http://localhost:8080。

6. 点击“Get started”并输入用户名。

7. 完成设置,现在可以在Web界面上与DeepSeek进行聊天了。

8. 要停止会话,右键点击系统托盘中的Ollama图标,然后选择“Quit Ollama”。

使用LM Studio将DeepSeek本地部署在电脑上

LM Studio也是一个可以下载DeepSeek模型的工具,例如DeepSeek Distill、DeepSeek Math和DeepSeek Coder。您可以前往LM Studio的模型目录查看可用的模型。

- 访问LMStudio.ai并在您的Mac、Windows或Linux计算机上下载LM Studio软件(0.3.9 或更高版本)。

- 启动LM Studio,在左侧面板中点击搜索图标。

- 在Model Search(模型搜索)栏下,选择DeepSeek R1 Distill (Qwen 7B) 模型,并点击Download(下载)按钮。该模型占用4.68GB 内存,因此您的电脑至少需要5GB可用存储空间和8GB RAM。

- 下载完成后,进入Chat窗口,加载模型。

- 点击Load Model(加载模型)按钮。可以将GPU offload设置为0以避免加载错误。

- 完成!现在您可以在电脑上离线使用DeepSeek了。

如何卸载Ollama和LM Studio中本地部署的DeepSeek

如果您需要删除已经部署好的DeepSeek模型,请按照以下步骤操作。

从Ollama中删除DeepSeek

1. 打开电脑上的命令提示符(Command Prompt)或终端(Terminal)。

2. 停止Ollama服务(如果正在运行):

ollama stop

3. 检查已安装的DeepSeek模型:

ollama list

4. 删除已安装的DeepSeek模型(以DeepSeek R1为例):

ollama remove deepseek-r1

5. 完成! 如果删除失败,请检查安装的模型名称是否正确。

6. 手动删除DeepSeek残留文件,文件路径如下:

- Linux/macOS: ~/ollama/models/

- Windows: C:\Users\<YourUsername>\ollama\models\

从LM Studio中删除DeepSeek

1. 打开LM Studio程序。

2. 在左侧面板中进入My Models(我的模型)选项卡。

3. 找到已安装的DeepSeek 模型。

4. 点击模型名称右侧的三点图标(…)。

5. 选择Delete(删除),然后点击Delete确认操作。

6. 检查DeepSeek文件是否已删除,对应的存储路径如下:

- Windows: C:\Users\<YourUsername>\LMStudio\Models\

- macOS: /Users/<YourUsername>/LMStudio/Models/

- Linux: /home/<YourUsername>/LMStudio/Models/

7. 完成!现在DeepSeek的本地文件已完全从您的计算机中移除。

将DeepSeek本地部署的优缺点

优点:

- 隐私和安全性:所有数据都会保存在您的设备上,DeepSeek和其他人无法访问您的敏感信息。

- 离线访问:一旦DeepSeek本地设置完成,就不需要互联网连接。您不必担心DeepSeek服务器繁忙的问题。

- 定制化:您可以微调或修改模型的行为、提示词和输出,以更好地适应您的特定需求或领域。

- 无速率限制:您不受API调用速率限制或使用配额的约束,可以进行无限次查询和实验。

- 成本效益:下载后,不需要为API调用或基于云的推理支付持续费用,而这些费用对于高频使用来说可能非常昂贵。

缺点:

- 高硬件要求:本地运行DeepSeek需要强大的计算资源。如果您的设备性能较低,体验可能会很差。

- 维护:您需要保持模型及其依赖项的更新,这可能是一个耗时的过程。如果出现其他问题(如bugs),您需要自己解决。

- 能耗:本地运行大型模型可能会消耗大量电力,特别是在使用GPU时,可能会增加电费。

结论

总体来说,只需几个简单的步骤,您就可以将DeepSeek本地部署。如今,越来越多的AI爱好者正在探索如何将AI工具部署到本地,如ChatGPT、Gemini和Claude。一些人几乎没有计算机相关知识,但通过这个过程,他们获得了很多知识。如果您也是计算机领域的初学者,阅读本文可能会帮助您设置自己的DeepSeek AI伴侣。