DeepSeekは優れたAIツールです。しかし、さまざまな理由で、多くのAI愛好者は自分のデバイスにローカルに展開したいと考えています。今日は、異なるデバイスでDeepSeekをローカルに展開する方法をガイドし、より高品質でプライベートなAIインタラクション体験を実現する手助けをします。

DeepSeekのオフライン展開は安全ですか?

DeepSeekは安全ですか?プライバシーポリシーによると、いくつかのデータ管理に関する詳細には不確実な点が残っています。たとえば、このポリシーではユーザーデータが中国の安全なサーバーに保存されることが述べられていますが、そのデータがどれくらい保存されるのか、または永久に削除できるかどうかは明記されていません。

とはいえ、TikTokや小紅書、Lemon8などの過去のケースを考えると、DeepSeekのユーザーデータが重大な問題に直面する可能性は極めて低いと考えられます。しかし、注意すべきは、DeepSeek上で不適切なコンテンツを投稿した場合、データが関連機関に提出される可能性があるという点です。

したがって、DeepSeekのデータ管理方法に不満がある場合、PCでのローカル展開は良い代替案となります。

ヒント:

データを保護する別の方法として、VPNを使用することが挙げられます。たとえば、LightningX VPN(閃連VPN)です。これは、AIツール(ChatGPT、Gemini、Claude、DeepSeekなど)に最適なVPNで、Android、iOS、Windows、macOS、Linux、Apple TV、Android TVに対応しています。このVPNでは、50か国以上の2000台以上のサーバーに接続でき、操作が簡単で、非常に高速で安定しています。現在、新規ユーザーには無料試用版が提供されています。

DeepSeekのローカル展開に必要なシステム要件

以下は、異なるデバイスでDeepSeekをローカルに実行するための基本的な要件です。

Android:

- プロセッサ:Snapdragon 845、Snapdragon 8 Gen 2/3、または同等の仕様

- メモリ:6GB、8GB、12GB、またはそれ以上

- ストレージスペース:8GB、12GB、またはそれ以上の空き容量

対応デバイス例:OnePlus 6、Samsung Galaxy S9、小米Pocophone F1、Google Pixel 3、Sony Xperia XZ2

iOS:

- メモリ:8GB、16GB、またはそれ以上

- 小型モデル対応:iPhone 15 Pro、iPad Air(8GBメモリ)

- 大型モデル対応:iPad Pro(16GBメモリ)

Windows:

- OS:Windows 10またはそれ以上

- メモリ:最低8GB(1.5Bなどの小型モデルに対応)、推奨16GB以上(大型モデルに対応)

- ストレージ:SSD、最低50GBの空き容量

- GPU:CUDA対応のNVIDIA GPU(RTX 2060以上を推奨、より良いパフォーマンスのため)

macOS:

- OS:macOS 11 Big Surまたはそれ以上

- プロセッサ:マルチコアCPU(Apple Silicon M1/M2またはIntel Core i5/i7/i9を推奨)

- メモリ:最低8GB(大型モデルを実行するためには16GB以上を推奨)

- ストレージ:最低10GBの空き容量(大型モデルを実行するためには50GB以上を推奨)

AndroidとiOSでDeepSeekをローカル展開するか、アプリをダウンロードする方法

もし、モバイルデバイスでDeepSeekを使用したい場合、Google PlayストアまたはApp Storeから公式アプリを直接ダウンロードするか、DeepSeekのローカルファイルをダウンロードしてオフラインで実行できます。

Google PlayストアまたはApp Storeからダウンロードする方法

DeepSeekアプリを取得する手順は以下の通りです:

- モバイルデバイスでGoogle PlayストアまたはApp Storeを開き、「DeepSeek」を検索します。

- アプリをダウンロードしてインストールします。

- インストールが完了したら、DeepSeekアカウントに登録し、R1モデルを有効にして、DeepSeekの利用を開始できます。

モバイルデバイスでDeepSeekをオフライン実行する方法

モバイルデバイスでDeepSeekをローカルに実行したい場合、ターミナルエミュレータを使用する必要があります。以下のアプリが推奨されます:

- PocketPal AI(AndroidおよびiOS用、初心者向け)

- Termux(Android用)

- Termius(iOS用)

以下は、PocketPal AIを使用してDeepSeekを実行する方法です:

- Google PlayストアまたはApp StoreからPocketPal AIをインストールします。

- アプリを開き、画面右下の「Go to Models」をクリックします。

- 右下の「+」をクリックし、「Add from Hugging Face」を選択します。これで、Hugging FaceライブラリにあるすべてのAIモデルが表示されます。

- 下部の検索バーに「DeepSeek」と入力すると、すべてのDeepSeek AIモデルが表示されます。

- デバイスに適したモデルをダウンロードします。例えば、7Bモデルは適度な選択肢です。前述のデバイス要件も参考にしてください。

- ダウンロードが完了したら、「Models」ページに戻り、モデルが正しくインストールされているか確認します。

- ダウンロードしたモデルの下にある「Settings」をクリックし、「N PREDICT」オプションでトークン制限を4096に設定して(生成と理解の体験を向上させるため)、その後「Save Changes」をクリックします。

- 「Settings」の隣にある「Load」をクリックします。

Ollamaを使用してWindows/Mac/LinuxにDeepSeekをローカル展開する方法

Ollamaは、LLMをローカルで実行する初心者向けのツールの中でも最適です。また、Windows、macOS、LinuxでOllamaを使用してDeepSeekのオフライン版をセットアップする方法はほぼ同じで、主に2つのステップから構成されています。

ステップ1:Ollamaデスクトップアプリをダウンロード

Ollamaの公式ウェブサイトにアクセスし、右上の「ダウンロード」ボタンをクリックします。ご自身のオペレーティングシステムに適したバージョンを選択してください。

Windows:Ollamaを直接インストールできます。

macOS:macOS用のダウンロードファイルは.dmg形式なので、Ollamaアイコンを「アプリケーション」フォルダにドラッグしてOllamaを実行します。

Linux:ターミナルで以下のコマンドを順番に入力します。各コマンドの役割は次の通りです。最初のコマンドはOllamaをインストール、2番目のコマンドはOllamaサービスを起動、3番目のコマンドはインストールが成功したかどうかを確認し、インストールされたバージョンを表示します。

- curl -fsSL https://ollama.com/install.sh | sh

- ollama serve

- ollama –version

Ollamaが正常にインストールされていれば、バージョン番号が表示されるはずです。

注意:コマンドプロンプトにコードを入力する際は注意してください。不適切なコマンドを入力するとデータが失われる可能性があります。

ステップ2:コマンドラインでDeepSeekをローカル展開

1. コンピュータでコマンドプロンプト(Windows)またはターミナル(macOS/Linux)を開きます。

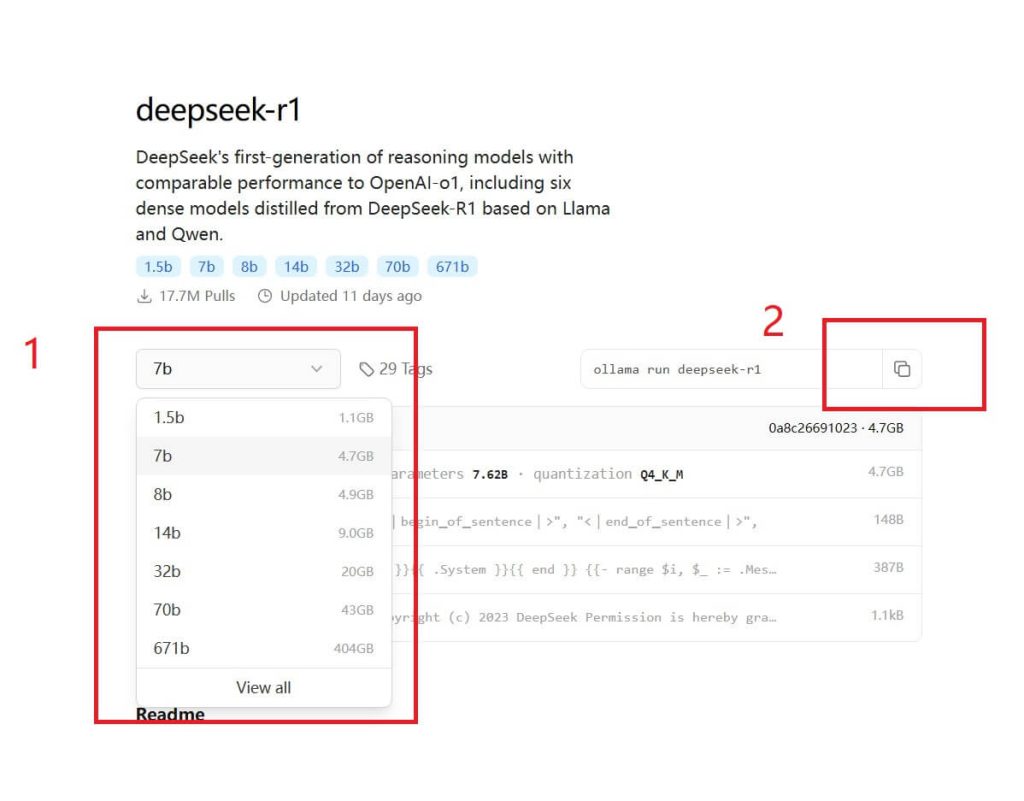

2. Ollama公式サイトで必要なDeepSeekモデルを検索し、該当するコードをコピーします。Ollamaは現在、DeepSeek R1、Coder、V2.5、V3など複数のバージョンをサポートしています。異なるモデルのパラメータ要件については、この記事の2部に詳しく記載されています。

3. コピーしたコードをコマンドプロンプトまたはターミナルに貼り付け、DeepSeekモデルのインストールが完了するのを待ちます。

4. インストールが完了したら、プロンプトを入力してDeepSeek AIとインタラクションを開始します。

5. 会話を終了するには、Ctrl + Dキーを押してください。

ステップ3:Web UIを使ってDeepSeekにアクセスしたい場合

ローカルで実行中のDeepSeekモデルをユーザーフレンドリーなWebインターフェースで使用したい場合は、Ollamaと互換性のあるOpen WebUIをインストールできます。

1. コンピュータにPythonとPipをインストールし、セットアップします。

2. コマンドプロンプトまたはターミナルを開き、以下のコマンドを入力してOpen WebUIをインストールします:

pip install open-webui

3. DeepSeekモデルを実行します(DeepSeek R1を例に取ります):

ollama run deepseek-r1:1.5b

4. Open WebUIを起動します:

open-webui serve

5. ブラウザで http://localhost:8080 にアクセスします。

6. 「Get started」をクリックし、ユーザー名を入力します。

7. セットアップが完了したら、WebインターフェースでDeepSeekとチャットできるようになります。

8. 会話を停止するには、システムトレイのOllamaアイコンを右クリックし、「Quit Ollama」を選択します。

LM Studioを使用してDeepSeekをコンピュータにローカル展開する方法

LM Studioは、DeepSeek Distill、DeepSeek Math、DeepSeek Coderなど、DeepSeekモデルをダウンロードできるツールの1つです。LM Studioのモデルディレクトリにアクセスして、利用可能なモデルを確認できます。

- LMStudio.aiにアクセスし、Mac、Windows、またはLinuxコンピュータにLM Studioソフトウェア(0.3.9以上のバージョン)をダウンロードします。

- LM Studioを起動し、左側のパネルで検索アイコンをクリックします。

- 「Model Search(モデル検索)」バーの下で、DeepSeek R1 Distill(Qwen 7B)モデルを選択し、「Download(ダウンロード)」ボタンをクリックします。このモデルは4.68GBのメモリを使用するため、コンピュータには少なくとも5GBの空きストレージと8GBのRAMが必要です。

- ダウンロードが完了したら、チャットウィンドウに移動してモデルを読み込みます。

- 「Load Model(モデルの読み込み)」ボタンをクリックします。GPUオフロードを0に設定することで、読み込みエラーを避けることができます。

- 完了です!これで、コンピュータでDeepSeekをオフラインで使用できるようになりました。

OllamaとLM Studioからローカルに展開したDeepSeekをアンインストールする方法

ローカルにインストールしたDeepSeekモデルを削除する必要がある場合は、以下の手順に従ってください。

OllamaからDeepSeekを削除する

1. コンピュータでコマンドプロンプト(Command Prompt)またはターミナル(Terminal)を開きます。

2. Ollamaサービスを停止します(実行中の場合):

ollama stop

3. インストールされているDeepSeekモデルを確認します:

ollama list

4. インストールされたDeepSeekモデルを削除します(例:DeepSeek R1の場合):

ollama remove deepseek-r1

5. 完了です!削除に失敗した場合は、インストールされたモデル名が正しいか確認してください。

6. DeepSeekの残存ファイルを手動で削除します。ファイルパスは以下の通りです:

- Linux/macOS: ~/ollama/models/

- Windows: C:\Users\<YourUsername>\ollama\models\

LM StudioからDeepSeekを削除する

1. LM Studioプログラムを開きます。

2. 左側のパネルで「My Models(マイモデル)」タブに移動します。

3. インストールされたDeepSeekモデルを見つけます。

4. モデル名の右側にある3点アイコン(…)をクリックします。

5. 「Delete(削除)」を選択し、削除操作を確認するために「Delete」をクリックします。

6. DeepSeekファイルが削除されたか確認します。対応するストレージパスは以下の通りです:

- Windows: C:\Users\<YourUsername>\LMStudio\Models\

- macOS: /Users/<YourUsername>/LMStudio/Models/

- Linux: /home/<YourUsername>/LMStudio/Models/

7. 完了です!これで、DeepSeekのローカルファイルはコンピュータから完全に削除されました。

DeepSeekのローカル展開の利点と欠点

利点:

- プライバシーとセキュリティ:すべてのデータはあなたのデバイスに保存され、DeepSeekや他の誰もあなたの機密情報にアクセスできません。

- オフラインアクセス:一度DeepSeekがローカルに設定されると、インターネット接続は必要ありません。サーバーが混雑する心配もありません。

- カスタマイズ:モデルの動作、プロンプト、出力を微調整したり変更したりして、特定のニーズや分野に合わせて最適化できます。

- 速度制限なし:API呼び出しの速度制限や使用クオータの制約を受けず、無制限にクエリや実験を行えます。

- コスト効果:ダウンロード後、API呼び出しやクラウドベースの推論に対して継続的な料金を支払う必要はありません。これらの料金は高頻度で使用する場合、非常に高額になる可能性があります。

欠点:

- 高いハードウェア要件:DeepSeekをローカルで実行するには強力な計算リソースが必要です。デバイスの性能が低い場合、体験が悪くなる可能性があります。

- メンテナンス:モデルとその依存関係を最新の状態に保つ必要があり、これは時間がかかる作業です。バグなどの問題が発生した場合は、自分で解決する必要があります。

- 電力消費:ローカルで大規模なモデルを実行すると、多くの電力を消費する可能性があり、特にGPUを使用している場合は電気料金が増加することがあります。

結論

全体として、DeepSeekをローカル展開するためには、いくつかの簡単な手順を踏むだけで済みます。現在、ますます多くのAI愛好者が、ChatGPT、Gemini、ClaudeなどのAIツールをローカルに展開する方法を模索しています。コンピュータに関する知識がほとんどない人々でも、このプロセスを通じて多くの知識を得ています。